突破Pick&Place,实现长程任务泛化!首个端到端强化学习具身模型Psi R0,横空出世

近日,灵初智能发布首个基于强化学习(RL)的端到端具身模型Psi R0。该模型支持双灵巧手协同进行复杂操作,将多个技能串联混训,生成具有推理能力的智能体,从而完成并闭环长程灵巧操作任务。并且,Psi R0还可以实现跨物品、跨场景级别的泛化。

真实世界中,人类生活近乎100%的场景涉及抓握、转动、捏取、触摸等操作,而其中超过 90% 的操作属于多技能融合的长程任务。然而在当下具身业界,多局限于Pick and Place操作的泛化,一旦任务复杂化、长程化,泛化性和成功率则大大降低,无法兼顾——这也是具身智能只能存在于demo,迟迟无法在真实场景中落地的核心原因!机器人如何突破Pick and Place、脱离遥操作,拥有自主完成长程灵巧操作的能力,实现真正类人的场景级任务闭环,仍是具身智能亟待攻克的难题。

RL是长程灵巧操作实现任务闭环的唯一解

在真实世界中,机器人解决长程任务必须通过Learning-based模式,目前主流技术路径有两种:模仿学习(IL)和强化学习(RL)。

纯模仿学习的泛化能力受限于示范行为的多样性和质量。加之长程任务步骤较多,更容易出现分布漂移问题,使得 IL实现长程任务的泛化性能较差,鲁棒性也较弱。

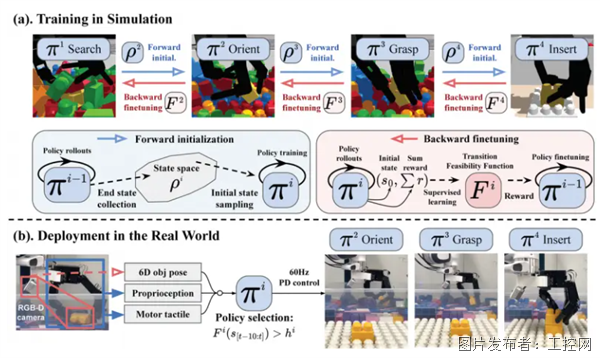

基于RL的Psi R0 模型,使用海量仿真数据高效训练出双手操作的智能体,并通过双向训练框架串联多技能,在业界率先完成开放环境中的长程任务,具备较强的泛化能力与较高的鲁棒性。这一技能训练框架从物体时空轨迹抽象出关键信息以构建通用目标函数,从而解决奖励函数难设计的问题。在后训练阶段,通过少量高质量真机数据对齐,进一步提升长程任务的成功率。除此之外,双向训练框架中的转移可行性函数发挥着重要作用,它能够微调技能以提高串联的成功率与泛化性,同时赋予模型自主切换技能的能力,使其在遭遇操作失败时能够迅速调整策略,确保高成功率。

真实世界中,人类生活近乎100%的场景涉及抓握、转动、捏取、触摸等操作,而其中超过 90% 的操作属于多技能融合的长程任务。然而在当下具身业界,多局限于Pick and Place操作的泛化,一旦任务复杂化、长程化,泛化性和成功率则大大降低,无法兼顾——这也是具身智能只能存在于demo,迟迟无法在真实场景中落地的核心原因!机器人如何突破Pick and Place、脱离遥操作,拥有自主完成长程灵巧操作的能力,实现真正类人的场景级任务闭环,仍是具身智能亟待攻克的难题。

RL是长程灵巧操作实现任务闭环的唯一解

在真实世界中,机器人解决长程任务必须通过Learning-based模式,目前主流技术路径有两种:模仿学习(IL)和强化学习(RL)。

纯模仿学习的泛化能力受限于示范行为的多样性和质量。加之长程任务步骤较多,更容易出现分布漂移问题,使得 IL实现长程任务的泛化性能较差,鲁棒性也较弱。

基于RL的Psi R0 模型,使用海量仿真数据高效训练出双手操作的智能体,并通过双向训练框架串联多技能,在业界率先完成开放环境中的长程任务,具备较强的泛化能力与较高的鲁棒性。这一技能训练框架从物体时空轨迹抽象出关键信息以构建通用目标函数,从而解决奖励函数难设计的问题。在后训练阶段,通过少量高质量真机数据对齐,进一步提升长程任务的成功率。除此之外,双向训练框架中的转移可行性函数发挥着重要作用,它能够微调技能以提高串联的成功率与泛化性,同时赋予模型自主切换技能的能力,使其在遭遇操作失败时能够迅速调整策略,确保高成功率。

扫码环节更是考验机器人的灵巧操作水平,需要双手高度精细地协调彼此相对位置,以确保扫码枪与商品条码能够精准对齐,任何细微偏差都可能导致扫码失败。此时,RL训练策略为双手双臂构成的高自由度复杂系统提供了可靠的实时闭环控制,保障扫码动作精准流畅地完成。

打包环节,需要双手协调完成对塑料袋的灵巧操作。在动态打包的过程中,塑料袋的形状会随动作变化,需要实时调整操作。为了提升机器人对柔性物体的操作适应能力,Psi R0在仿真环境中模拟多种柔性物体的操作场景,同时结合真机数据进行微调优化。甚至在被打断、干扰的情况下,也能自适应调整策略,重新进行打包动作。

灵初智能Psi R0模型是具身智能递归性成长的第一步。具身智能将遵从从简单到复杂、从保护到协同的渐进式演进。在早期,小脑是与真实世界交互的物理基础,其设计需结合领域知识,满足环境中的约束条件,同时具备容错性,支持大脑学习与优化。Psi R0模型发挥RL算法探索的优势,支持小脑的快速迭代,生成支持长程灵巧操作的智能体。通过灵巧操作转动数据飞轮,实现从小脑Action到大脑Cognition的闭环回馈,驱动大脑认知能力优化,模型持续迭代,形成小脑协同+大脑优化的具身智能“神经回路”,使端到端模型完成从简单到复杂、从保护到协同的渐进式演进。返回搜狐,查看更多

提交

龙芯携手中冶南方发布GIC通用智能控制器,共筑工业智控新生态

福禄克声学新品震撼上市

AI智启生活 第15届深圳国际移动电子展亮点“剧透”

电装与NTT DATA联合解读SDV时代:智能汽车如何重塑未来出行?

GRAEFF(格拉夫)2025 CHINAPLAS 国际橡塑展邀请函

投诉建议

投诉建议